hbm:sk海力士、三星、美光三分天下-yb体育app官网

来源:全球半导体观察 原作者:奉颖娴

半导体产业步入下行周期之际,2023年chatgpt的“走红”为产业带来新的发展方向:ai人工智能。

chatgpt正掀起一场声势浩大的ai浪潮,ai时代下,为满足海量数据存储以及日益增长的繁重计算要求,半导体存储器领域也迎来新的变革,hbm技术从幕后走向台前,未来前景可期。

突破“内存墙”瓶颈,hbm应运而生

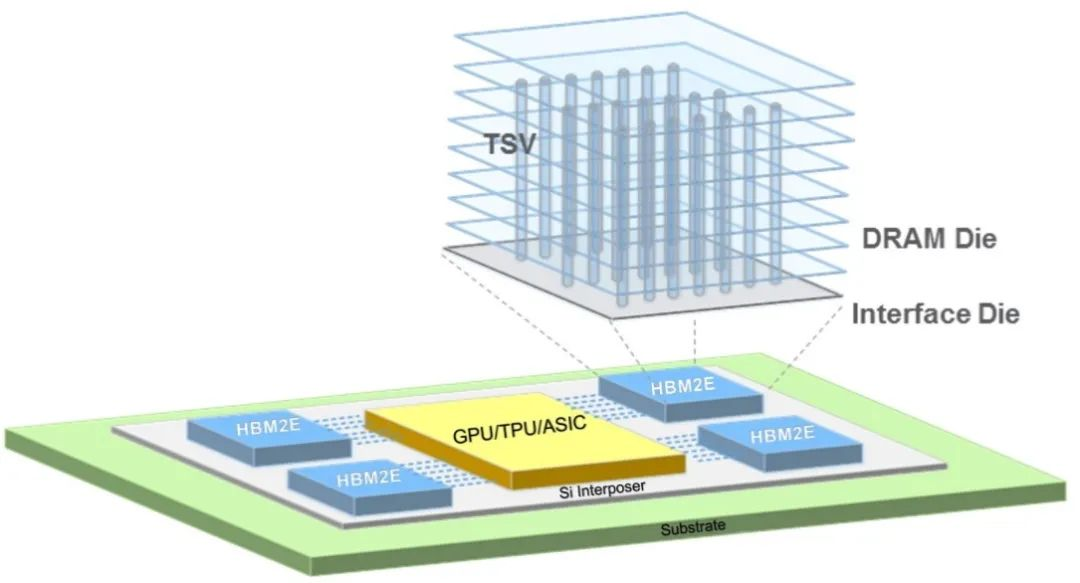

hbm(high bandwidth memory)即高带宽存储器,按照jedec的分类,hbm属于图形ddr内存的一种,其通过使用先进的封装方法(如tsv硅通孔技术)垂直堆叠多个dram,并与gpu封装在一起。

hbm通过硅通孔技术实现垂直堆叠

图片来源:美光科技

存储器与处理器性能差异正随时间发展逐渐扩大,当存储器访问速度跟不上处理器数据处理速度时,存储与运算之间便筑起了一道“内存墙”。而随着人工智能、高性能计算等应用市场兴起,数据爆炸式增长之下,“内存墙”问题也愈发突出。为此,业界希望通过增加存储器带宽解决大数据时代下的“内存墙”问题,hbm便应运而生。

存储器带宽是指单位时间内可以传输的数据量,要想增加带宽,最简单的方法是增加数据传输线路的数量。据悉,典型的dram芯片中,每个芯片有八个dq数据输入/输出引脚,组成dimm模组单元之后,共有64个dq引脚。而hbm通过系统级封装(sip)和硅通孔(tsv)技术,拥有多达1024个数据引脚,可显著提升数据传输速度。

hbm技术之下,dram芯片从2d转变为3d,可以在很小的物理空间里实现高容量、高带宽、低延时与低功耗,因而hbm被业界视为新一代内存yb体育app官方下载的解决方案。

.png)

图表:全球半导体观察整理

资料来源:sk海力士

自2014年首款硅通孔hbm产品问世至今,hbm技术已经发展至第四代,分别是:hbm(第一代)、hbm2(第二代)、hbm2e(第三代)、hbm3(第四代),hbm芯片容量从1gb升级至24gb,带宽从128gb/s提升至819gb/s,数据传输速率也从1gbps提高至6.4gbps。

chatgpt效应下,hbm需求持续看涨

与传统dram相比,hbm具备高带宽、高容量、低延时与低功耗等优势,可以加快ai数据处理速度,更适用于chatgpt等高性能计算场景。

当前chatgpt等aigc(生成式人工智能)模型需要使用ai服务器进行训练与推理,其中训练侧ai服务器基本需要采用中高端gpu,如nvidia a100/h100等,在这些gpu中,hbm的渗透率接近100%;而推理侧ai服务器尽管目前采用中低端gpu,hbm渗透率不高,不过随着aigc模型逐渐复杂化,未来推理侧ai服务器采用中高端gpu将是发展趋势,未来这一领域的hbm渗透率也将快速提升。

chatgpt风靡之下,ai效应正持续发酵,并不断渗透云端/电商服务、智能制造、金融保险、智慧医疗及智能驾驶辅助等各行各业,ai服务器与高端gpu需求不断上涨,并有望持续推动hbm市场成长。

全球市场研究机构trendforce集邦咨询预估2023年ai服务器(包含搭载gpu、fpga、asic等)出货量近120万台,年增38.4%,占整体服务器出货量近9%。其中,nvidia gpu为ai服务器市场搭载主流,市占率约60~70%。

.png)

从高端gpu搭载的hbm来看,nvidia高端gpu h100、a100主采hbm2e、hbm3。以今年h100 gpu来说,搭载hbm3技术规格,其中传输速度也较hbm2e快,可提升整体ai服务器系统运算效能。随着高端gpu如nvidia的a100、h100;amd的mi200、mi300,以及google自研的tpu等需求皆逐步提升,集邦咨询预估2023年hbm需求量将年增58%,2024年有望再成长约30%。

hbm市场格局:sk海力士、三星、美光三分天下

hbm是新一代内存yb体育app官方下载的解决方案,其市场被三大dram原厂牢牢占据。集邦咨询调查显示,2022年三大原厂hbm市占率分别为sk海力士50%、三星约40%、美光约10%。

公开资料显示,sk海力士是hbm市场的先行者,也是全面布局四代hbm的厂商。2014年,sk海力士与amd联合开发第一代硅通孔hbm产品;2018年sk海力士发布第二代hbm产品hbm2;随后2020年sk海力士发布第三代hbm——hbm2e,作为hbm2的扩展版本,性能与容量进一步提升;2021年10月sk海力士成功开发出第四代产品hbm3,并于2022年6月开始量产,今年4月,该公司进一步宣布,已经全球率先研发出12层堆叠的hbm3内存,单颗容量可达24gb。

三星对hbm的布局从hbm2开始,目前,三星已经向客户提供了hbm2和hbm2e产品。2016年三星量产hbm2;2020年三星推出了hbm2;2021年2月,三星推出了hbm-pim(存算一体),将内存半导体和ai处理器合二为一;2022年三星表示hbm3已量产。另据媒体报道,三星已于今年4月26日向韩国专利信息搜索服务提交“snowbolt”商标申请,预估该商标将于今年下半年应用于dram hbm3p产品。

美光进军hbm相对较晚,相关产品公开报道不多。2020年美光表示将开始提供hbm2产品,用于高性能显卡,服务器处理器产品。另据业界透露,美光亦在发力最新hbm3产品。

集邦咨询指出,2023下半年伴随nvidia h100与amd mi300的搭载,三大原厂也已规划相对应规格hbm3的量产。其中,在今年将有更多客户导入hbm3的预期下,sk海力士作为目前唯一量产新世代hbm3产品的供应商,其整体hbm市占率可望藉此提升至53%,而三星、美光则预计陆续在今年底至明年初量产,hbm市占率分别为38%及9%。

结语

当然,对于新一代内存yb体育app官方下载的解决方案而言,hbm并非十全十美,现阶段hbm成本高昂,这就意味着该项技术暂时只能在服务器等高端领域应用,此外由于和主芯片封装在一起,出厂已经确定规格,难以进行容量扩展,因此在服务器等领域,会出现hbm ddr搭配使用的方案。

不过总体而言,在chatgpt、人工智能训练和推理以及高性能计算等助力下,市场需要更多极速内存,hbm未来很长的时间内都将大有用武之地。

封面图片来源:拍信网

微信公众平台

微信公众平台