blackwell出货在即,cowos总产能持续看增,预估2025年增率逾7成|trendforce集邦咨询-yb体育app官网

来源:集邦咨询

trendforce集邦咨询:blackwell出货在即,cowos总产能持续看增,预估2025年增率逾7成

根据trendforce集邦咨询研究,nvidia hopper平台h100于今年第一季短缺情形逐渐纾解,属同平台的新品h200于第二季后逐渐放量,第三季新平台blackwell将进入市场,第四季扩展到数据中心客户。但今年应仍以hopper平台为主,包含h100、h200等产品线;根据供应链导入blackwell平台进度,预计今年第四季才会开始放量,占整体高阶gpu比例将低于10%。

trendforce集邦咨询表示,属blackwell平台的b100等,其裸晶尺寸(die size)是既有h100翻倍,估计台积电(tsmc)2024年cowos总产能年增来到150%,随着2025年成为主流后,cowos产能年增率将达7成,其中nvidia需求占比近半。hbm方面,随着nvidia gpu平台推进,h100主搭载80gb的hbm3,至2025年的b200将达搭载288gb的hbm3e,单颗搭载容量将近3~4倍成长。而据三大原厂目前扩展规划,2025年hbm生产量预期也将翻倍。

microsoft、meta、aws将首波采用gb200

据trendforce集邦咨询研究,以云端服务业者(csp)导入现况来看,以microsoft、meta、aws较为积极,预期2025年gb200方案合计出货量有机会达逾30,000柜,google则可能倾向优先扩大自家tpu ai基础设施。blackwell平台之所以备受市场期待,主要是有别于hgx或mgx单台ai服务器,改推整柜式型态,整合自家cpu、gpu、nvlink及infiniband等高速网通技术。其中,gb200又分为nvl36及nvl72,每柜分别搭载达36及72颗gpu,而nvl72将为nvidia主推组态,但因其设计较为复杂,估计2024年底将以nvl36先导入前期试练,以求快速进入市场(time to market)。

2024年ai服务器需求持续扩大

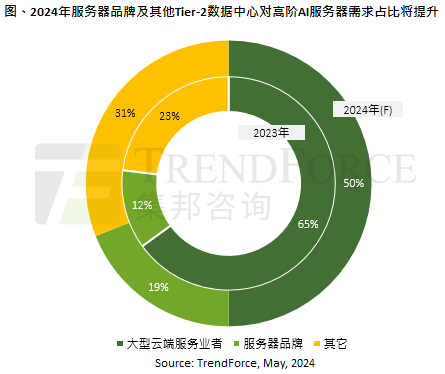

据nvidia fy1q25资料来看,企业客户、tier-2数据中心客群需求明显提升。trendforce集邦咨询表示,受限于2023年cowos及hbm供应不及,如nvidia优先将其高阶gpu提供给大型云端服务业者(hyper csp),以全球高阶ai server整体市场来看,2023年csp合计对ai服务器的需求量占比约65%。

自2024年上半年随gpu供货短缺获缓解后,今年来自服务器品牌商如dell、hpe的需求占比将扩大至19%;其他包含各地区tier-2数据中心如coreweave、tesla等,或各国超算中心项目等,合计需求占比将提高至31%,主因ai训练或应用过程中,可能涉及数据隐私安全等议题,预期未来此块市场也将扮演驱动ai服务器出货成长的关键。

微信公众平台

微信公众平台