受ai加速芯片新品带动,hbm3与hbm3e将成为2024年hbm市场主流|trendforce集邦咨询-yb体育app官网

来源:集邦咨询

trendforce集邦咨询: 受ai加速芯片新品带动,hbm3与hbm3e将成为2024年hbm市场主流

根据trendforce集邦咨询调查显示,2023年hbm(high bandwidth memory)市场主流为hbm2e,包含nvidia a100/a800、amd mi200以及多数csps自研加速芯片皆以此规格设计。同时,为顺应ai加速器芯片需求演进,各原厂计划于2024年推出新产品hbm3e,预期hbm3与hbm3e将成为明年市场主流。

hbm各世代差异,主要以速度做细分。除了市场已知的hbm2e外,在进入hbm3世代时,产业出现较为混乱的名称。trendforce集邦咨询特别表示,目前市场所称的hbm3实际需细分为两种速度讨论,其一,5.6~6.4gbps的hbm3;其二,8gbps的hbm3e,别名hbm3p、hbm3a、hbm3 、hbm3 gen2皆属此类。

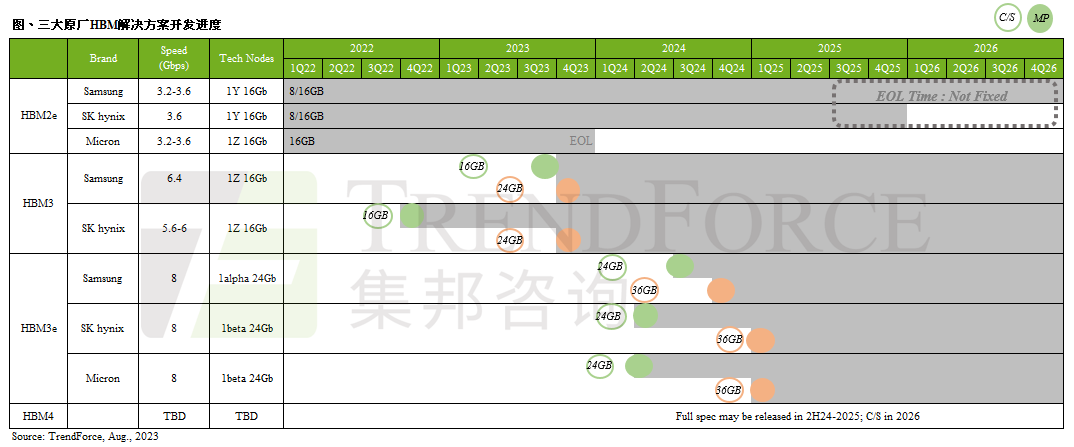

目前三大原厂hbm发展进度如下,两大韩厂sk海力士(sk hynix)、三星(samsung)先从hbm3开发,代表产品为nvidia h100/h800以及amd的mi300系列,两大韩厂预计于2024年第一季送样hbm3e;美系原厂美光(micron)则选择跳过hbm3,直接开发hbm3e。

hbm3e将由24gb mono die堆栈,在8层(8hi)的基础下,单颗hbm3e容量将一口气提升至24gb,此将导入在2025年nvidia推出的gb100上,故三大原厂预计要在2024年第一季推出hbm3e样品,以期在明年下半年进入量产。

csp陆续启动自研ai加速芯片计划,欲摆脱对nvidia与amd的依赖

观察ai服务器(ai server)所用的加速芯片,其中英伟达(nvidia)server gpu市占最高。然而,单张20,000~25,000美元的h100/h800,一台ai服务器建议配置约为8张卡,也使得总体拥有成本(total cost of ownership,tco)大幅提升。trendforce集邦咨询观察到,各云端服务业者(csp)虽然仍会向nvidia或超威(amd)采购server gpu,但也同步进行自研ai加速芯片的计划。

除了已经推出的google tpu与aws trainium和inferentia外,google与aws正着手研发次世代自研ai加速芯片,将采用hbm3或hbm3e。trendforce集邦咨询表示,其他包含北美及中国的云端服务业者亦有相关验证进行中,预期未来ai加速芯片版图竞争会更加激烈。

微信公众平台

微信公众平台