ai狂潮,gpu短缺严重,先进封装火力全开!-yb体育app官网

来源:全球半导体观察 原作者:竹子

如果说2016年击败李世石的使用强化学习模型的alphago(阿尔法围棋)没有给你留下深刻影响,那么基于大语言模型技术的chatgpt应足以让你感慨,ai的脚步越来越贴近我们的生活,我们对于ai所带来的变动感知越来越清晰。

从广义上讲,只要能够运行人工智能算法的芯片都叫作ai芯片。而从ai运算过程看,其贯穿了云-边-端,因此又可分为云端芯片、边端芯片、终端芯片,外加一个适配海量数据的存储芯片。具体到技术架构层面,ai芯片主要分为图形处理器(gpu)、现场可编程门阵列(fpga)、专用集成电路(asic)、中央处理器(cpu)等类脑芯片四大类。

当下正值国内外大模型爆发期,算力缺口出现,gpu芯片引起市场关注。

01

gpu:每家都需要,每家都在抢

当下大部分的现象级ai产品如chat gpt背后的算力支撑主要来自gpu或cpu fpga。其中gpu的火热远超cpu。“gpu专为加速计算和生成式ai而设计,未来你需要更少的cpu,gpu的连接将会更加普遍。”英伟达ceo黄仁勋表示。

大模型对于gpu的性能和数量要求都很高,据前人工智能nlp企业首席科学家、千芯科技董事长陈巍测算,国内如果想要直接训练出一个gpt-3级别的大模型,最少需要3000到5000枚a100级别的ai芯片。以保守情况估计,目前国内a100级别的ai芯片缺口在30万枚左右。

ai大火以后,英伟达旗下a100、h100、a800和h800等高性能gpu芯片应声涨价,一度被调侃为新一代理财产品。国内外消息显示,其旗舰级芯片h1004月中旬在海外电商平台就已炒到超4万美元,甚至有卖家标价6.5万美元。英伟达的中国特供版a800和h800芯片也不例外,近日一位经销商表示,目前其手中nvidia a800的售价已较一周上涨约30%,服务器现货则由120多万元一台涨至接近140万元。

那个爱穿皮衣的男人最先尝到了ai红利。在上市14年之后,英伟达成功跻身万亿美元市值俱乐部,而实现这一目标,硅谷巨头们诸如苹果用了37年、微软用了33年、亚马逊用了21年,特斯拉跑得最快,只用了11年。

不过,在gpu爆火大潮下,也难以逃脱如2020年车规芯片短缺的境遇。gpu的供应短缺到了何种程度呢?当下即使如openai,也无法获得足够的gpu,马斯克表示,这严重阻碍了其近期路线图。

业界消息显示,gpu缺口还在加速扩大。此前已有媒体报道今年拥有云端相关业务的企业,大多都向英伟达采购了大量gpu,目前该公司订单已排至2024年。

02

产能跟不上,先进封装是关键

gpu芯片供应短缺的背后,与先进封装产能供应不足息息相关。从从供应链角度看,先进封装一定程度上影响着ai芯片的放量速度。

行业消息显示,目前nvidia a100、h100 gpu完全由台积电代工生产,搭载第三代hbm(高带宽内存),并使用台积电cowos先进封装技术,此外博通、amd等芯片公司也在争抢台积电cowos产能,导致台积电产能压力大增。

面对先进封装cowos产能爆满,近日在2023年第二季度线上法说会上,台积电表示,到2024年cowos产能将扩充2倍以上。台积电总裁魏哲家表示,与ai芯片相关的一些高级封装可能在2024年底之前仍然供应紧张。因此,需求可能在相当长的时间内持续超过供应,因为amd和英伟达将无法扩大生产至某个点,尽管某些4nm和5nm的产能是可用的。

近期,媒体报道为满足市场需求,台积电已向disco、apic yamada及台厂辛耘、弘塑等先进封装设备供应商启动第三波追单。

03

响应需求,hbm加速开发

由于目前几乎所有的hbm系统都封装在cowos上,hbm存储本质上也属于先进封装的一部分。

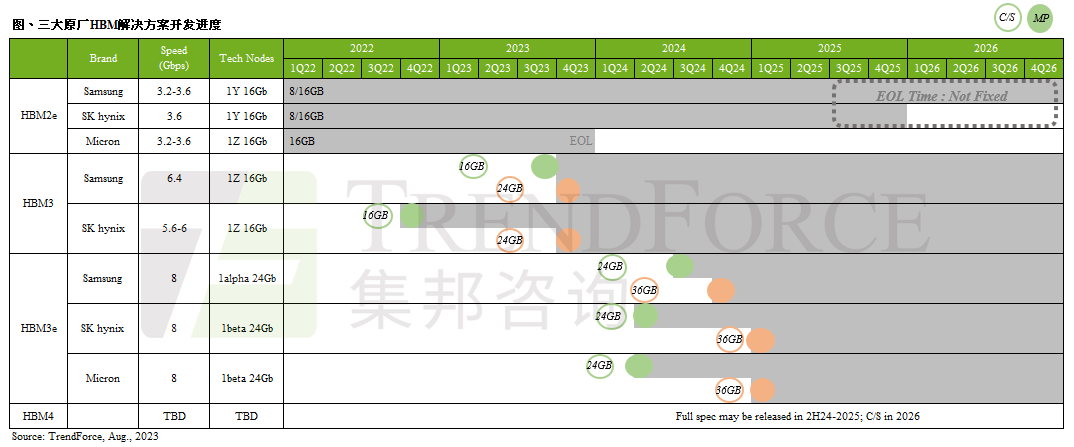

根据trendforce集邦咨询调查显示,2023年hbm(high bandwidth memory)市场主流为hbm2e,包含nvidia a100/a800、amd mi200以及多数csps自研加速芯片皆以此规格设计。同时,为顺应ai加速器芯片需求演进,各原厂计划于2024年推出新产品hbm3e,预期hbm3与hbm3e将成为明年市场主流。

trendforce集邦咨询特别表示,目前市场所称的hbm3实际需细分为两种速度讨论,其一,5.6~6.4gbps的hbm3;其二,8gbps的hbm3e,别名hbm3p、hbm3a、hbm3 、hbm3 gen2皆属此类。

目前三大原厂hbm发展进度如下,两大韩厂sk海力士(sk hynix)、三星(samsung)先从hbm3开发,代表产品为nvidia h100/h800以及amd的mi300系列,两大韩厂预计于2024年第一季送样hbm3e;美系原厂美光(micron)则选择跳过hbm3,直接开发hbm3e。

hbm3e将由24gb mono die堆栈,在8层(8hi)的基础下,单颗hbm3e容量将一口气提升至24gb,此将导入在2025年nvidia推出的gb100上,故三大原厂预计要在2024年第一季推出hbm3e样品,以期在明年下半年进入量产。

封面图片来源:拍信网

微信公众平台

微信公众平台